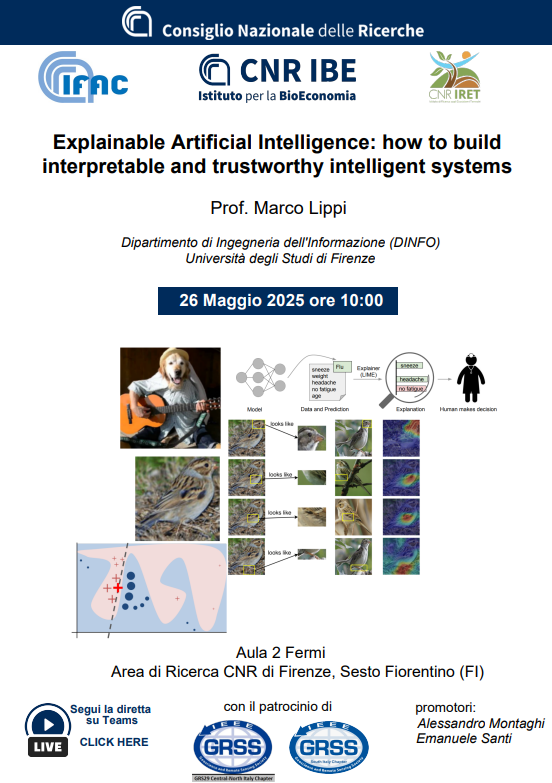

lla capacità di automatizzare compiti complessi, come l’elaborazione di grandi quantità di dati o l’identificazione di schemi, e alla sua crescente accessibilità al grande pubblico. Tuttavia, nonostante l’uso sempre più diffuso dell’IA, molti sistemi continuano a operare in modi poco trasparenti per tutte le parti coinvolte: i soggetti che li sviluppano, le organizzazioni che li adottano e le persone influenzate dal loro utilizzo. In molti casi, persino i provider non sono in grado di spiegare con precisione come i loro sistemi giungano a determinate decisioni o risultati. Questo fenomeno è comunemente noto come il problema della “Black Box”. L’Intelligenza Artificiale Spiegabile (XAI) si propone di affrontare questa sfida, rendendo i sistemi di IA capaci di fornire spiegazioni chiare e comprensibili delle loro azioni e decisioni. Il suo obiettivo principale è rendere il comportamento di tali sistemi trasparente e comprensibile per gli esseri umani, chiarendo i meccanismi alla base dei processi decisionali.